L’Intelligenza artificiale è un settore in espansione, che interessa moltissimi ambiti: dal lavoro, alla sanità, passando per l’e-commerce e il giornalismo, fino all’arte e così via.

Ma l’ultima frontiera è a dir poco innovativa, si tratta delle nuove tecnologie artificiali applicate agli animali, più in particolare utilizzate per cercare di riprodurre il movimento dei cani.

Leggi anche: Machine Learning e Intelligenza Artificiale: dalla cultura al giornalismo, tutti gli utilizzi

Come comportarsi come un cane

Finora i sistemi di apprendimento automatico sono stati eseguiti per identificare gli oggetti, navigare nelle strade e riconoscere le espressioni facciali, ma per quanto difficile possa essere, non toccano il livello di sofisticazione richiesto per simulare, ad esempio, un cane.

La ricerca

La ricerca

Il progetto è nato grazie alla collaborazione tra l‘Università di Washington e l’Allen Institute for A.I., il piano completo, relativo di dati e risultati, sarà presentato al CVPR nel prossimo mese di giugno.

Sebbene finora siano state fatte molte sperimentazioni per simulare i sotto-compiti della percezione come identificare un oggetto e raccoglierlo, poco invece è stato fatto in termini di “comprensione dei dati visivi nella misura in cui un agente può intraprendere azioni ed eseguire compiti nel mondo visivo”. In altre parole, l’intelligenza artificiale non riesce ancora a comportarsi come l’occhio, ma come la cosa che controlla l’occhio.

Perché dunque sperimentare il comportamento di un cane? Perché sono considerati “agenti intelligenti” di sufficiente complessità, “ma i loro obiettivi e le loro motivazioni sono spesso sconosciute a priori “, dunque i cani sono chiaramente intelligenti, ma la maggior parte delle volte non abbiamo idea di cosa stiano pensando.

Come prima incursione in questa linea di ricerca, il team di studio del progetto ha provato a monitorare da vicino il cane e, mappando i suoi movimenti e le sue azioni nell’ambiente che vede, ha cercato di ricreare un sistema che prevedesse con precisione quei determinati movimenti.

Leggi anche: Intelligenza Artificiale Sanità, un mercato da 6,6 miliardi di dollari

I risultati

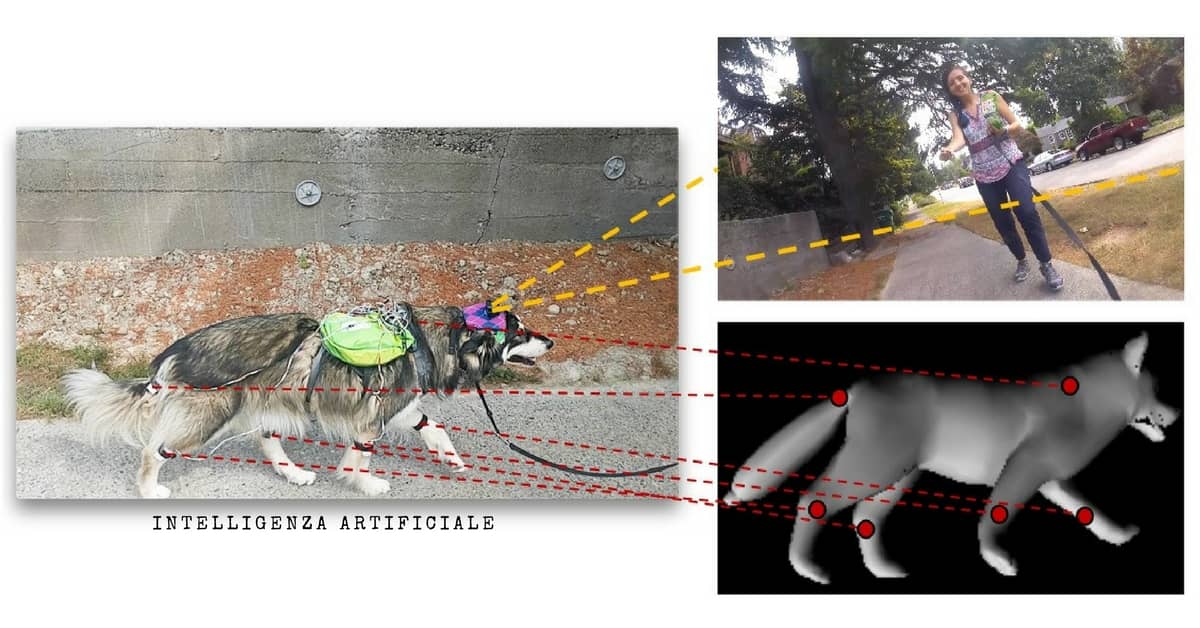

Come ci sono riusciti? Hanno caricato un dispositivo Malamute di nome Kelp M. Redmon con una suite di sensori di base. Integrata anche una videocamera GoPro sulla testa di Kelp, sei unità di misurazione inerziale (sulle gambe, sulla coda e sul dorso), compreso un microfono e un Arduino che legano insieme i dati.

La ricerca ha così registrato molte ore di attività: il cane è stato seguito in ogni suo movimento camminando in vari ambienti, prendendo cose, giocando in un parco, mangiando e tutto ciò è stati prontamente sincronizzato con ogni suo spostamento, vedendo ciò che vedeva l’animale.

Il risultato è stato poi usato per addestrare un nuovo agente di intelligenza artificiale per cani.

Questo agente, dato un certo input sensoriale era in grado di prevedere cosa avrebbe fatto un cane in quella situazione. Ovviamente non con un livello di dettaglio infallibile, ma abbastanza preciso per capire come spostare il corpo e dove a seconda delle informazioni registrate.

L’intelligenza artificiale “impara a muovere le articolazioni per camminare, impara come evitare gli ostacoli camminando o correndo“, ha spiegato Hessam Bagherinezhad, uno dei ricercatori: ”impara a correre inseguendo gli scoiattoli, il padrone, i giocattoli. Questi sono alcuni dei compiti di base dell’I.A. nella visione artificiale e nella robotica che abbiamo cercato di risolvere raccogliendo dati separati per ogni attività (ad esempio pianificazione del movimento, superficie calpestabile, rilevamento di oggetti, rilevamento di oggetti, riconoscimento della persona)“.

L’intelligenza artificiale “impara a muovere le articolazioni per camminare, impara come evitare gli ostacoli camminando o correndo“, ha spiegato Hessam Bagherinezhad, uno dei ricercatori: ”impara a correre inseguendo gli scoiattoli, il padrone, i giocattoli. Questi sono alcuni dei compiti di base dell’I.A. nella visione artificiale e nella robotica che abbiamo cercato di risolvere raccogliendo dati separati per ogni attività (ad esempio pianificazione del movimento, superficie calpestabile, rilevamento di oggetti, rilevamento di oggetti, riconoscimento della persona)“.

Il progetto in sè può produrre dati piuttosto complessi: ad esempio, il “modello cane” deve sapere, proprio come fa il cane stesso, dove può camminare e quando ha bisogno di fare un determinato percorso. Deve infatti saper riconoscere che non può camminare su alberi, o auto, o su divani e mobili di casa. Così, il modello apprende anche questo, e può essere implementato separatamente come un modello di visione del computer per scoprire dove un animale domestico (o un robot dalle piccole zampe) può arrivare attraverso una determinata immagine.

Si tratta di un primo esperimento, dicono i ricercatori, con risultati estremamente positivi, ma limitati. Altri potrebbero considerare di introdurre più sensi (come studiare e riprodurre i meccanismi dell’olfatto) o vedere come un modello prodotto da un cane si generalizza rispetto ad altri cani. La conclusione di Bagherinezhad è comunque positiva: “Speriamo che questo progetto apra la strada verso una migliore comprensione dell’intelligenza visiva e degli altri esseri intelligenti che abitano il nostro mondo“.

Leggi anche: Robotica: Boston Dynamics, ecco un nuovo amico a 4 zampe